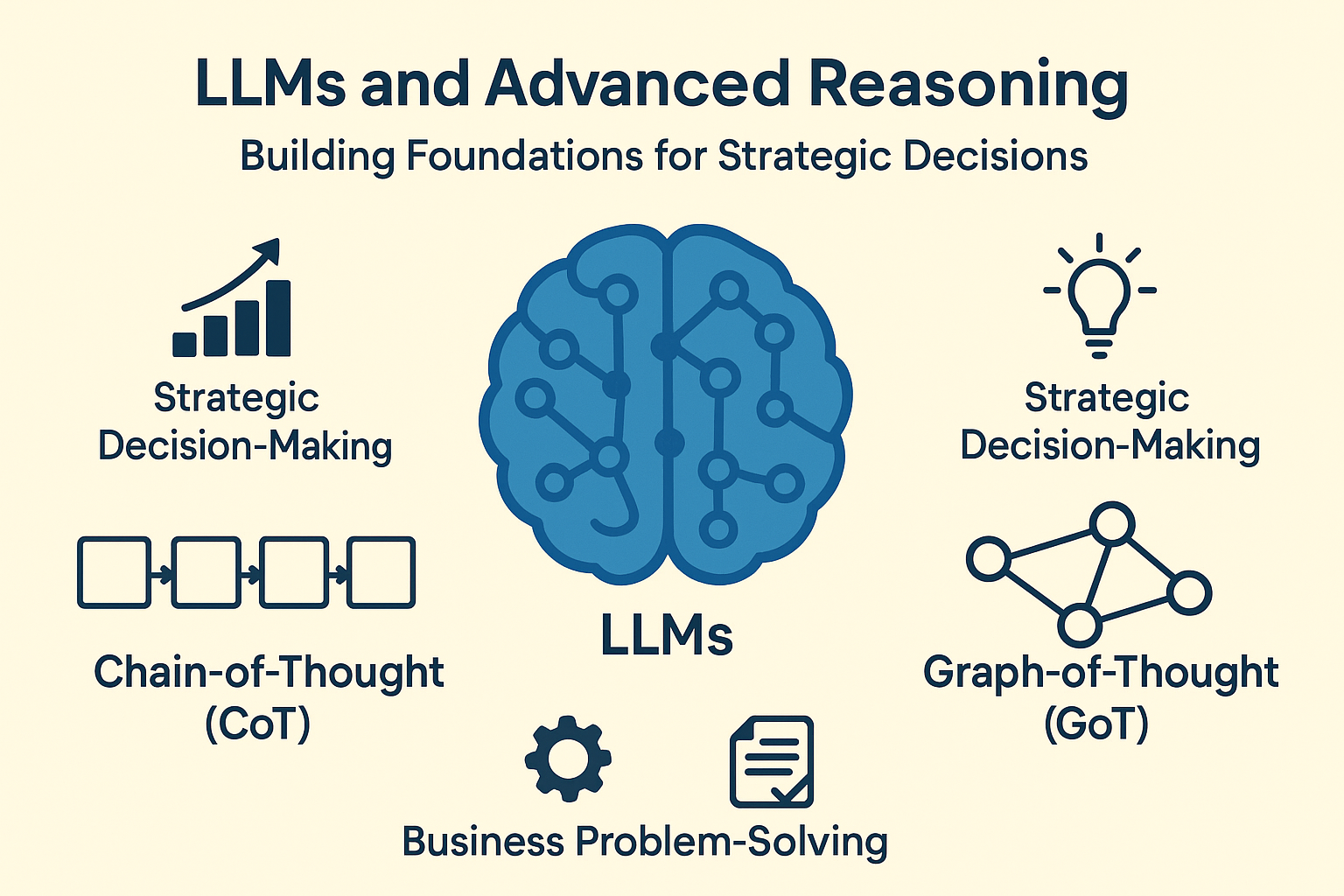

LLMs e Raciocínio Avançado: Construindo Fundamentos para Decisões Estratégicas

Nos últimos anos, os Modelos de Linguagem de Grande Escala (LLMs) transformaram a forma como interagimos com a informação e resolvemos problemas complexos. Mas além de gerar texto coerente, esses modelos têm um potencial ainda maior: o raciocínio avançado para suportar decisões estratégicas e resolver desafios de negócios de alta complexidade.

O Projeto 2 do nosso pipeline de pesquisa e experimentos tem como objetivo explorar profundamente esse potencial, avaliando técnicas modernas que aprimoram o reasoning em LLMs, como Chain-of-Thought (CoT) e Graph-of-Thought (GoT). Essas abordagens permitem que os modelos simulem processos de raciocínio humano, decompondo problemas complexos em etapas ou representando múltiplas linhas de pensamento conectadas, elevando significativamente a capacidade de análise e tomada de decisão.

Por que raciocínio avançado é importante?

Embora LLMs sejam excelentes em gerar respostas gramaticalmente corretas e contextualmente relevantes, tarefas estratégicas em negócios exigem mais do que texto coerente — exigem capacidade de raciocínio estruturado, análise de cenários complexos e proposição de soluções integradas. Por exemplo:

-

Avaliação de riscos e oportunidades em projetos estratégicos

-

Otimização de processos de negócios com múltiplas variáveis interdependentes

-

Suporte à tomada de decisão em ambientes incertos

Técnicas de aprimoramento do reasoning em LLMs

1. Chain-of-Thought (CoT)

O CoT estimula o modelo a descrever passo a passo seu raciocínio, em vez de fornecer uma resposta direta. Esse método melhora a precisão em tarefas que requerem inferência lógica ou multi-etapas, como:

-

Análises financeiras complexas

-

Planejamento estratégico de projetos

-

Diagnóstico de problemas empresariais com múltiplas causas

2. Graph-of-Thought (GoT)

Enquanto o CoT segue uma linha sequencial, o GoT permite que o modelo construa uma rede de pensamentos interconectados, simulando cenários de raciocínio paralelo. Ideal para:

-

Mapear dependências e interações entre variáveis de negócios

-

Simular múltiplos cenários estratégicos simultaneamente

-

Tomada de decisão colaborativa e iterativa

3. Outras abordagens complementares

-

Graph-of-Thought (GoT)

-

Técnicas de verificação de consistência e autovalidação

-

Uso de memória e histórico de contexto para manter coerência em raciocínios longos

Aplicações práticas em negócios

Integrar raciocínio avançado de LLMs em empresas permite:

-

Suporte a decisões estratégicas complexas, reduzindo riscos e aumentando a assertividade

-

Geração de insights acionáveis a partir de grandes volumes de dados não estruturados

-

Otimização de processos e identificação de oportunidades antes mesmo de análises humanas tradicionais

Próximos passos

Antes de avançarmos para experimentações práticas com LLMs, este projeto propõe:

-

Revisão detalhada dos fundamentos teóricos e arquiteturais de LLMs

-

Exploração das técnicas CoT e GoT em contextos de negócios

-

Desenvolvimento de uma base sólida para experimentos futuros, garantindo que qualquer aplicação prática seja fundamentada em conhecimento robusto

Leia também:

Se você gostou deste tema, confira nosso artigo complementar “Técnicas para Aprimorar LLMs em Ambientes Empresariais: CoT, GoT e RAG”, onde exploramos mais a fundo como essas técnicas se comparam, se complementam e como aplicá-las estrategicamente no ambiente corporativo.

Referências iniciais

-

Wei, J., et al. (2023). Chain-of-Thought Prompting Elicits Reasoning in Large Language Models.

-

Zhou, K., et al. (2023). Graph-of-Thought: Structured Reasoning in LLMs.

-

Brown, T., et al. (2020). Language Models are Few-Shot Learners. NeurIPS 2020.

-

Manning, C., et al. (2023). Foundations of Large Language Models: Theory and Practice.

Voltar para Projetos de Pesquisa em Andamento e Experimentos

Deixe um comentário